自然言語処理(NLP)の分野で最近注目を浴びているのが、トランスフォーマーモデルです。その中でも特に有名なBERTやGPT-3などのモデルは、文章や単語を「特徴ベクトル」という数値の形で表現します。これらの特徴ベクトルは、単語の意味を数値の形で表現していますが、これらの数値が具体的に何を意味するかを直接解釈することは非常に困難です。それぞれの次元が具体的に何を表しているのかを指定することはできません。これは、特徴ベクトルが高次元空間で単語の意味を捉えているためで、その各次元が具体的に何を意味するかを一意に定義することは現状では困難です。

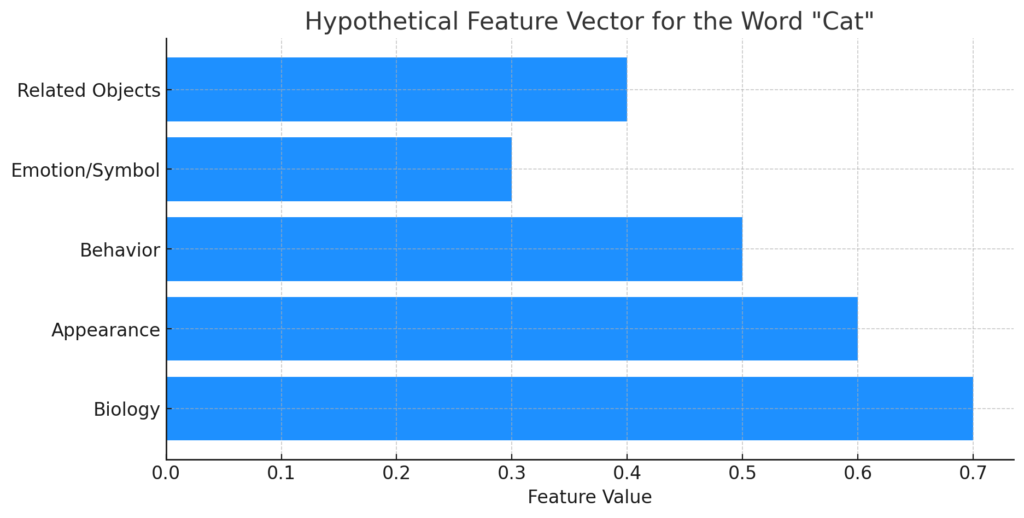

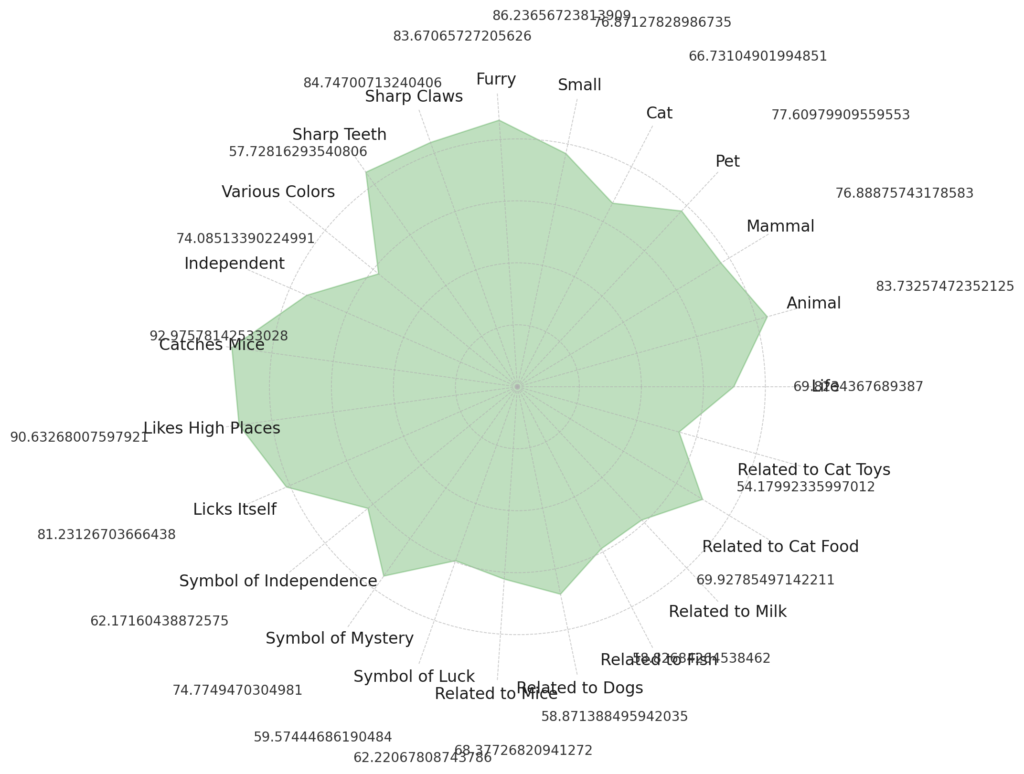

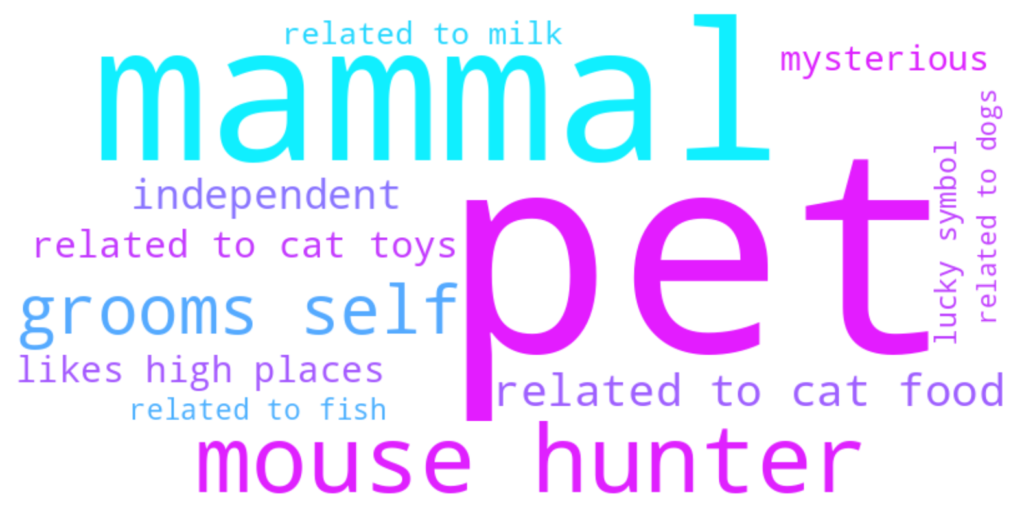

しかし、その特徴ベクトルがどのように働くかの一般的なアイデアを考えてみることはできます。”猫”という単語に対する1000次元の特徴ベクトルを考えてみましょう。以下に、その一部を想像するためのアサンプションと例を挙げてみます:

これらの要素は、”猫”という単語の特徴ベクトルが持つ可能性のある情報を一部示しています。しかし、これはあくまで一例であり、実際の特徴ベクトルがこれらの要素をどのように、またどの程度捉えているかは、モデルの訓練方法や用いられたデータセットによります。

このように、特徴ベクトルは高度に抽象化された情報を持っており、それぞれの次元が具体的に何を表すかを一意に定義することは困難です。しかし、それらが持つ可能性のある情報を考えることで、我々はモデルの挙動を理解しようとする試みを進めていくことができます。

□更なる考察のための補足①:

美術館に飾られている絵画のような非常に詳細な猫の描写を生成するためには、非常に多くの特徴量を捉える必要があります。その数は数千から数百万、あるいはそれ以上になる可能性があります。

その理由は、美術館に飾られている絵画のような詳細な描写をするには、猫の形状や姿勢、色、模様、質感などの視覚的特徴だけでなく、猫が存在する環境や光の当たり方、背景との関係性など、多岐にわたる情報を表現する必要があるからです。また、そのような描写を生成するためには、それらの特徴量をうまく組み合わせて表現する能力も必要になります。

しかしながら、これは描写の精度や詳細さにもよります。たとえば、単純な猫のスケッチを描くのであれば、それほど多くの特徴量は必要としません。しかし、リアルな猫の描写や、特定の猫の個体を正確に描写するためには、より多くの特徴量を捉える必要があります。

また、この質問には、人間の芸術家がどの程度の情報を意識的・無意識的に処理しているか、という興味深い観点もあります。たとえば、絵画を描く際に、芸術家がどの程度の詳細な情報を意識的に考え、どの程度を無意識のうちに描いているのか、という問いも関連します。この観点から見ると、人間の芸術家が描写を生成する際に利用している「特徴量」の数は、意識的なものと無意識的なものを合わせると、さらに多くなる可能性があります。

□更なる考察のための補足②

ドラえもんは「猫型ロボット」という設定ですが、彼が「猫」の特徴をどれだけ持っているかは、どの特徴を「猫らしい」特徴として捉えるかによります。そのため、その数は非常に主観的で、人により異なると思われます。

例えば、以下のような特徴を考えてみましょう:

以上のように、ドラえもんが猫の特徴をどれだけ持っているかを判断するには、どの特徴を「猫らしい」特徴とするかを定義する必要があります。

したがって、特徴量という観点から見ると、「猫」の特徴量のうち、ドラえもんが持っているものは一部に過ぎないかもしれません。しかし、「猫型ロボット」という観点から見ると、彼が持つ特徴量は非常に多く、独自のものも多いと言えるでしょう。

(参考)